17.03.2022 Ein Gastbeitrag von Markus Raatz & Felix Wolf*

Die Funktechnologie LoRaWAN bietet vielfältige Anwendungsmöglichkeiten für das sensorbasierte IoT. Geschäftsanalyse-Dienste helfen dabei, große Datenmengen aus verschiedenen Quellen zu analysieren und in Echtzeit zu visualisieren – wir geben einen Überblick.

(Bild: gemeinfrei / Unsplash)

LoRaWAN steht für Long Range Wide Area Network. Der lizenzfreie Funkstandard gehört zu den Low-Power-Wide-Area-Network-Technologien, kurz LPWAN. LoRaWAN überträgt Sensordaten mit wenig Energie auch über große Distanzen und bietet eine hohe Gebäudedurchdringung.

Die Sensoren sind einfach konstruiert. Das macht sie preiswert und flexibel einsetzbar. Im Vergleich zu anderen Technologien können Betreiber die Netzwerkinfrastruktur selbst aufbauen. So entsteht keine Abhängigkeit von einem Netzbetreiber und der Anwender behält die Kontrolle über seine Daten. Ein Stadtwerk beispielsweise steht in der Verantwortung hinsichtlich der Datensicherheit und damit der Privatsphäre der Bürger. LoRaWAN bietet eine sichere Grundlage, denn das Protokoll arbeitet mit einer zweistufigen symmetrischen Verschlüsselung. Zudem wird der Schlüssel niemals per Funk übertragen.

IoT-Daten in der Cloud speichern

Immer mehr Unternehmen nutzen eine Cloud für ihre IT-Ressourcen. Auch viele Betreiber eines LoRaWAN-basierten IoT wollen ihre Daten in einer Cloud speichern und sie dynamisch visualisieren. Der Netzwerk-Server The Things Stack führt direkt zu Amazon Web Service (AWS), wo The Things Stack AWS Launcher eine einfache Lösung bietet. Auch die Cloud-Dienste der anderen Anbieter wie Google, IBM, Microsoft oder SAP bieten leistungsfähige Dienste in den Bereichen Data Analytics und Data Insights.

Microsoft hat den Vorteil, dass die Nutzer- und Berechtigungsverwaltung durch eine Integration mit dem Active Directory gut mit vorhandenen Lösungen wie Microsoft Office harmoniert. Wer professionelle Business-Applikationen wünscht, die sich in die bestehende Software-Infrastruktur integrieren lassen, sollte sich die Azure Cloud ansehen. Fast alle Microsoft-Produkte zielen darauf ab, dass deren Daten am Ende hier landen, um in Echtzeit Auswertungen zu visualisieren. Azure präsentiert ein großes Angebot an endnutzertauglichen Anwendungen in vielen Sprachen, die sich ohne die Expertise von teuren Spezialisten nutzen lassen.

IoT-Daten in Echtzeit visualisieren

Eine Datenkultur aufbauen, datengetriebene Entscheidungen ermöglichen, auch Fachanwendern die Arbeit mit den eigenen Daten erleichtern: Das geht mit Self-Service-Datenauswertungs-Software wie Microsofts Power BI. Sobald man die Berichte und Dashboards für andere Nutzer im Web-Browser zugänglich machen will, muss man sie auf powerbi.com veröffentlichen und landet in der Azure Cloud.

Lizenztechnisch sind Power BI und Azure zwei Paar Schuhe. Power BI ist in Microsoft 365 enthalten. Wer das Paket nicht hat, muss derzeit 8,40 Euro pro Benutzer und Monat für eine Lizenz zahlen. Anwender können die Messwerte von Plattformen wie The Things Network automatisch an Power BI weiterleiten. Ein Grund dafür, warum man seine Daten mit Power BI analysieren sollte, ist ihr schiere Menge: Während bei Excel schon nach einer Million Zeilen Schluss ist, ist bei Power BI der Hauptspeicher die einzige Grenze.

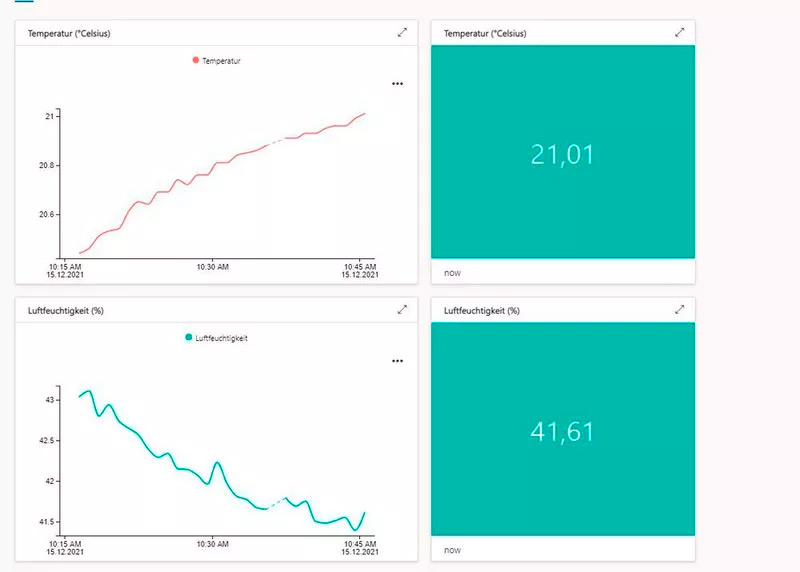

Eines der schönsten Features ist die automatisch animierte Anzeige der Echtzeit-Streaming-Daten im Web-Browser. Die Power BI Echtzeitdatensets bieten jede Menge Diagrammtypen, die sich jeweils noch weiter konfigurieren lassen. Wenn das nicht ausreicht, bietet die Community noch Custom Visuals an.

Ein Blick zurück ermöglicht Vorhersagen

Oft reicht es nicht, die Daten der letzten Stunden zu beobachten, sondern es geht darum, viele Wochen oder Monate in die Vergangenheit zu schauen. So werden weit zurückliegende Fehler genauso sichtbar wie der als golden Batch bezeichnete Moment, in dem alles perfekt funktioniert hat. Und nicht zuletzt bauen KI-Vorhersagen auf den Daten der Vergangenheit auf.

Hierfür müssen gigantische Mengen an Daten langfristig sicher gespeichert werden. Amazon hat die S3 Storage, Google die Google Cloud Storage und Microsoft hat die Azure Blob Storage. Für alle gilt: Das ausfallsichere Lagern riesiger Datenmengen in Dateiform ist preiswert, konkret: das Gigabyte Daten abzulegen kostet in Azure in der sogenannten Cool Storage, die für die Langzeitspeicherung schon ausreicht, derzeit 0,00863 Euro im Monat. Anwender müssen also von den riesigen Datenmengen, die IoT-Geräte liefern, nie wieder etwas löschen. Alles kann in der Cloud gesammelt werden. Getreu dem Motto: „Todays noise is tomorrows information“

Azure Functions: Ein guter Ort für IoT-Messwerte

Sollen die Messwerte von The Things Stack in die Azure Cloud, führt der Weg über Custom Webhooks. In Azure sind die Daten in der kostengünstigen und flexiblen Komponente Azure Functions gut aufgehoben. Dabei handelt es sich um Serverless-Funktionen, die man selbst entwickeln muss. Man nutzt dazu Programmiersprachen wie Java, C#, JavaScript oder PowerShell, sollte also Skripting-Kenntnisse mitbringen.

Azure Functions sind vergleichbar mit Google Cloud Functions und mit AWS Lambda. Der Vorteil von solchen Serverless-Routinen ist, dass sie dafür gebaut sind, von Events ausgelöst zu werden, worauf sie dann ein Stück Code ausführen und sich wieder beenden. Die Kosten für den Aufruf werden in Form von Microbilling einzeln abgerechnet. Finden plötzlich tausende von Events statt, dann skaliert die Infrastruktur dahinter transparent und dynamisch hoch.

IoT Central und IoT Hub: Für Lösungen im Eigenbau

Eine der spannendsten Lösungen, die man über eine Azure Function mit Echtzeit-Daten versorgen kann, ist Azure IoT Central. Die SaaS-Lösung stellt ein einfaches Portal zur Verfügung, die IoT Central Application, mit der auch Fachanwender professionelle IoT-Systeme bauen können. Mit den Daten, die aus den Geräten kommen, kann man schon sehr viel machen, ohne eine Zeile Code schreiben zu müssen: So lassen sich Regeln definieren, die Aktionen starten. Und es gibt die Möglichkeit, die Daten zur dauerhaften Speicherung in eine Blob Storage zu schreiben. Auch ein einfaches Reporting-System ist verfügbar.

Dashboards in IoT Central sind nicht spektakulär, aber dafür leicht zu bauen. So kann fast jede und jeder im Unternehmen Geräte einbinden, überwachen und Daten visualisieren. IoT Central ist eine simple, grafische Oberfläche mit nur einigen der Möglichkeiten, die der IoT Hub bietet. Er ermöglicht es unter anderem, die Geräte-Software auch vom IoT Hub aus zentral zu aktualisieren und zu verwalten. Sein Top-Feature bietet die Möglichkeit, auch einen Rückkanal vom IoT Hub zum Gerät eröffnen zu können. Allerdings hat das auch seinen Preis: Die kostenfreie Version kann maximal 8.000 Nachrichten am Tag empfangen, und maximal 500 Geräte verwalten. Danach steigen die Preise mit der Skalierung.

Event Hub: Hoher Datendurchsatz für Echtzeit-Streaming

Auch der Event Hub ist eine Komponente des IoT Hub, der sich einzeln nutzen lässt. Das Tool bietet einen hohen Datendurchsatz für Streaming in Echtzeit im Web mit sehr guter Skalierungsmöglichkeit. Hier reden wir von Big Data, denn der Event Hub schafft auch Milliarden von Anforderungen am Tag.

Doch auch für wenige hundert Nachrichten kann es sich lohnen, ihn in die Architektur aufzunehmen. Das Tool ist in diesem Fall sehr günstig und viele andere Tools aus dem Microsoft IoT-Portfolio haben eine direkte Anschlussmöglichkeit – so etwa Databricks, Stream Analytics, Azure Datalake Store und HD Insight. Auch praktisch: Mit Event Hub Capture lasse sich die Daten aller Events, die hier ankommen, parallel in eine günstige Blob Storage wegschreiben, so dass sie dort für eine Archivierung oder Langzeit-Auswertung bereit liegen.

Azure Stream Analytics: Für Datensparsame

Nicht jeder Anwender braucht die vielen Milliarden Nachrichten täglich, die der Event Hub weiterleiten kann. Oft ist jede Nachricht zwar wichtig, aber was man aus dem Datenstrom herausziehen will, sind Aggregatwerte über ein Zeitfenster: Was ist die Durchschnittstemperatur der letzten fünf Minuten? Was sind Max- und Min-Wert jeweils für jede Viertelstunde?

Genau dieses Complex Event Processing bietet Stream Analytics. Die Abfragen laufen auf dem hereinlaufenden Datenstrom, ohne ihn aufzuhalten und die Aggregat-Werte als Ergebnisse der Abfrage können weitergesendet werden – sie enthalten dann nur noch sinnvolle Zusammenfassungen. Die Ausgabetypen sind sehr offen und vielfältig: Blob Storage, SQL-Datenbank oder Azure Synapse Analytics, Cosmos DB, Service Bus oder Azure Functions – aber vor allem Power BI für die grafische, animierte Darstellung der Daten in Echtzeit.

Dieser Gastbeitrag von Markus Raatz (Ceteris AG) und Felix Wolf (Alpha_Omega Technology) wurde veröffentlicht in der Industry of Things und BigData Insider.